El Microprocesador (1971): El día que el cerebro del ordenador cupo en un chip

Publicado el 9 de diciembre de 2025

El Microprocesador (1971): El día que el cerebro del ordenador cupo en un chip

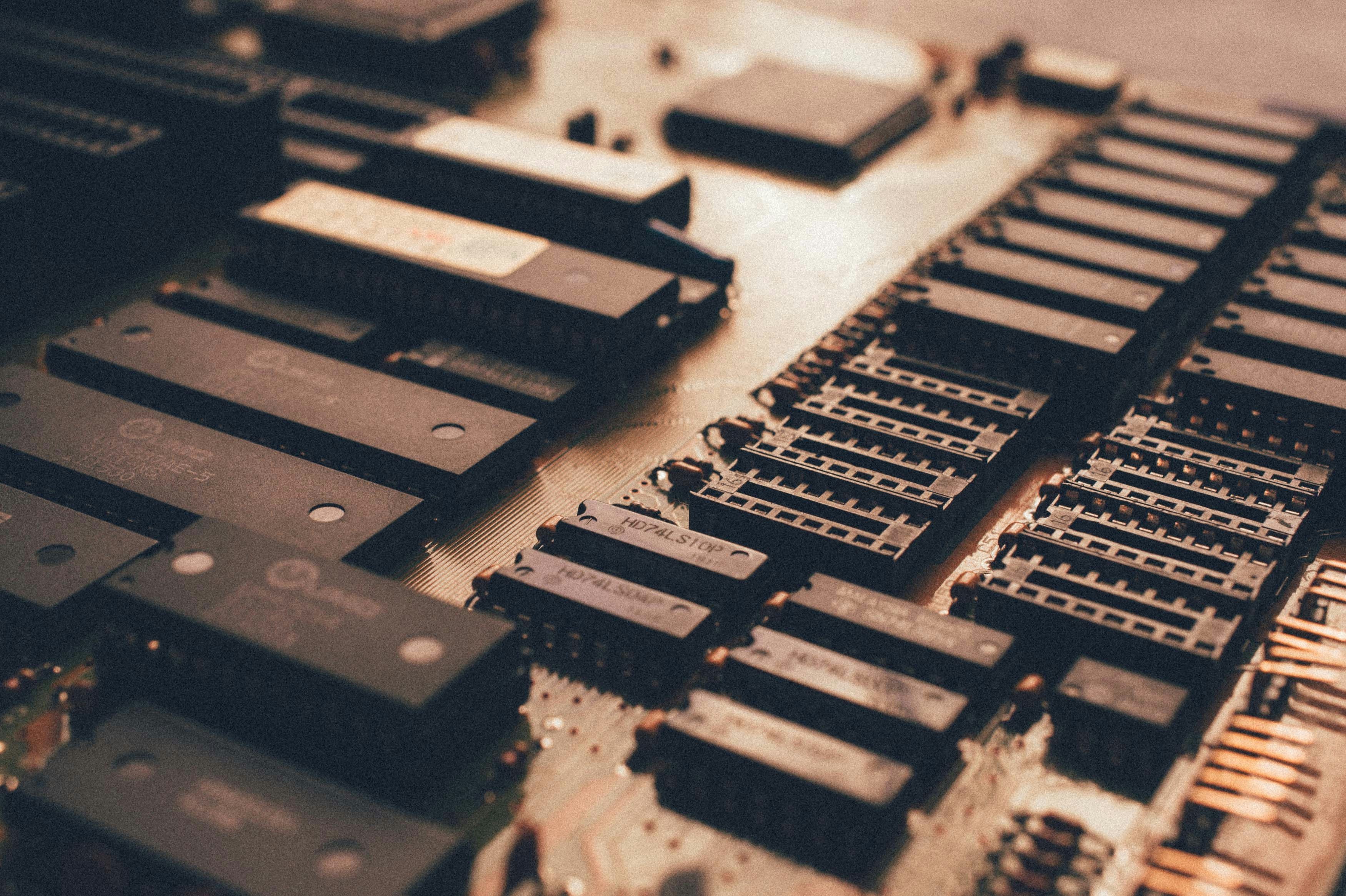

Si abres la carcasa de tu ordenador, verás una placa base llena de componentes, pero hay uno que destaca sobre todos los demás. Suele estar escondido bajo un gran ventilador, protegido como si fuera una joya. Y lo es. Es el cerebro de la máquina.

Hoy, martes 9 de diciembre de 2025, continuamos nuestro recorrido por los 10 momentos que definieron la tecnología. Ya hemos visto el transistor (el cuerpo), el circuito integrado (la estructura) y ARPANET (la comunicación). Pero faltaba algo crucial. Antes de 1971, las "Unidades Centrales de Procesamiento" (CPU) eran conjuntos de varias placas electrónicas conectadas por cables. Eran caras y difíciles de fabricar.

Hoy hablamos del día en que los ingenieros lograron meter todo ese cerebro en una sola pastilla de silicio. Hablamos del Intel 4004, el primer Microprocesador de la historia.

Un encargo japonés y una idea rebelde

La historia de cómo nació el microprocesador es el ejemplo perfecto de cómo buscar la eficiencia puede llevar a la revolución.

En 1969, una empresa japonesa de calculadoras llamada Busicom se acercó a una joven startup llamada Intel. Busicom quería crear una nueva calculadora de alto rendimiento y le pidió a Intel que fabricara 12 chips diferentes para controlar las distintas funciones (teclado, pantalla, impresora, sumas, etc.).

Los ingenieros de Intel, liderados por Ted Hoff y Federico Faggin, miraron el diseño y pensaron: "Esto es una locura. Es demasiado complejo y caro de fabricar".

En lugar de hacer lo que el cliente pedía, propusieron una idea radical: ¿Y si en lugar de hacer 12 chips especializados, hacemos un solo chip que sea "programable"?

Nace el "Cerebro Universal"

La idea era brillante. En lugar de tener hardware fijo para cada tarea, crearían un hardware genérico que pudiera cambiar su función obedeciendo instrucciones de software.

En noviembre de 1971, Intel lanzó el 4004.

Tenía 2.300 transistores.

Procesaba 4 bits de información a la vez.

Era tan potente como la ENIAC (el ordenador gigante de 1946), pero cabía en la punta de un dedo.

Por primera vez, la lógica de un ordenador no estaba en los cables, sino en el silicio. Habían creado una CPU completa en un solo chip.

¿Por qué cambió las reglas del juego?

Para nosotros, como desarrolladores, el microprocesador marca el inicio de la era del software tal como la conocemos. Antes del 4004, si querías que una máquina hiciera algo diferente, a menudo tenías que rediseñar el circuito físico.

El microprocesador introdujo la flexibilidad total:

- Programabilidad: El mismo chip podía controlar una calculadora, un semáforo o un misil. Solo tenías que cambiar el código, no el chip.

- Democratización: Al reducirse drásticamente el coste y el tamaño de la CPU, la computación dejó de ser exclusiva de empresas millonarias. Hizo posible el Ordenador Personal (PC). Sin el microprocesador, Steve Wozniak nunca habría podido diseñar el Apple I en su garaje unos años más tarde.

- Inteligencia en todo: Permitió poner "cerebros" en objetos cotidianos. Lavadoras, coches, microondas... la "inteligencia embebida" nació aquí.

Conclusión

El Intel 4004 puede parecer un juguete comparado con los procesadores actuales (que tienen miles de millones de transistores y núcleos especializados en IA), pero su arquitectura básica sigue siendo la misma.

Ese pequeño chip de 1971 nos enseñó que el poder real no está en hacer herramientas para una sola tarea, sino en crear plataformas capaces de aprender cualquier tarea a través del código. Fue el momento en que el hardware le cedió el trono al software.

¿Qué sigue? Ahora que tenemos un cerebro pequeño y barato, ¿qué pasa si lo ponemos en manos de la gente común en sus propias casas? El próximo post será sobre la revolución del Ordenador Personal. ¡Mantente conectado!

Foto de Carlos Irineu da Costa en Unsplash